Musica e intelligenza artificiale: a che punto siamo

L’utilizzo dell’intelligenza artificiale in campo musicale è sempre più diffuso e nel medio lungo termine potrebbe portare a grossi cambiamenti nella discografia per come l’abbiamo sempre conosciuta.

L’utilizzo dell’intelligenza artificiale in campo musicale è sempre più diffuso e nel medio lungo termine potrebbe portare a grossi cambiamenti nella discografia per come l’abbiamo sempre conosciuta.

Lo scorso 28 gennaio Motherboard ha pubblicato una lettera in cui Nick Cave risponde a un proprio fan, Peter. Il ragazzo chiede al cantautore se l’intelligenza artificiale sarà mai in grado di scrivere belle canzoni. La risposta di Nick Cave è abbastanza chiara: “No.” Ma sembra più la speranza di un autore navigato che una possibilità concreta.

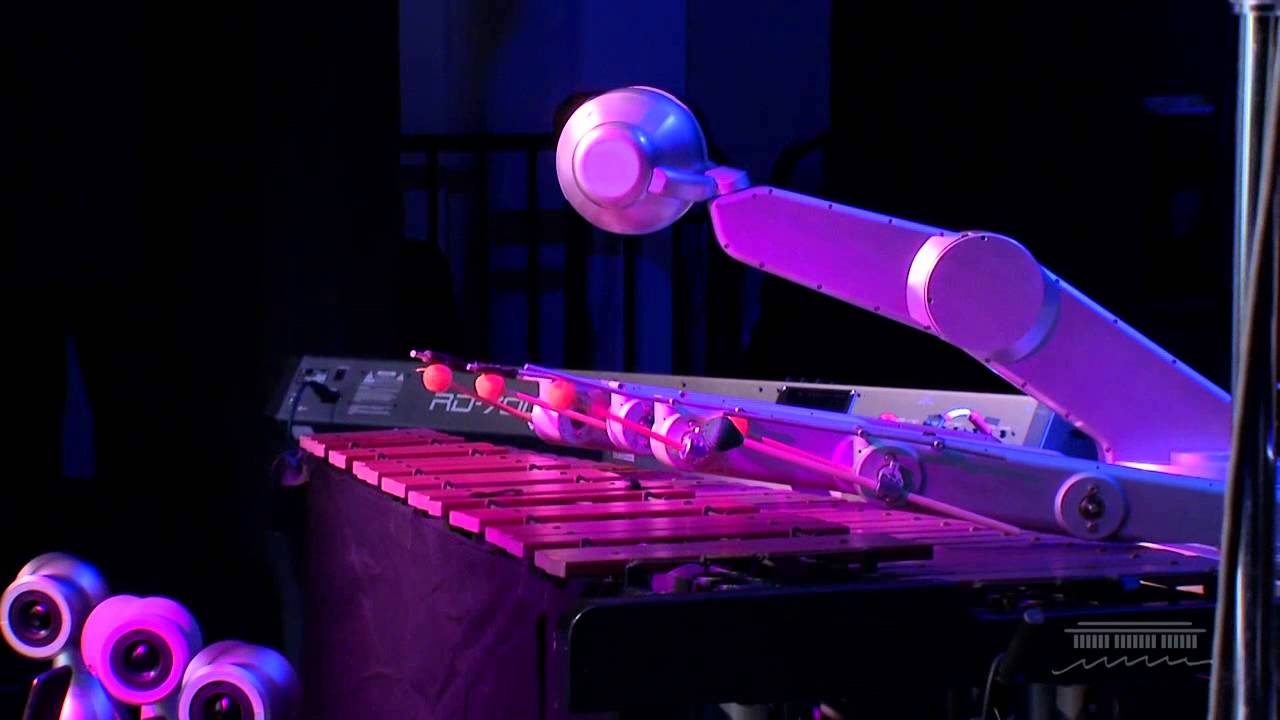

Dagli esperimenti di Sony con il sistema Flow Machines che hanno portato nel 2016 all’uscita di Daddy’s Car (un brano dichiaratamente basato sui pezzi dei Beatles) alla produzione di colonne sonore in ambito cinematografico, l’uso dell’intelligenza artificiale in campo musicale non sta ancora producendo delle vere hit discografiche ma è sempre più diffuso e sta portando a risultati incoraggianti.

Vengono sfruttate le reti neurali – modelli matematici molto semplificati delle reti neurali biologiche – e il machine learning. In sostanza si danno in pasto ai computer migliaia di brani che vengono sminuzzati e analizzati per elaborare canzoni “simili” a quelle prodotte dagli artisti in carne e ossa. Ma come sottolineato da Paolo Armelli nell’ultimo numero di Wired (cartaceo):

“le applicazioni dell’IA in questo settore sono potenzialmente infinite e ultimamente la tendenza è applicarla anche alla scrittura dei testi. Scomponendo vastissimi cataloghi di testi e canzoni in segmenti linguistici minimi, sempre individuati in base a criteri specifici a partire dal genere (pop, rock o addirittura musica classica), è possibile ricombinare gli elementi in liriche che, sebbene ancora non perfette, cercano di ricalcare la naturalità dei testi di autori ‘umani.’”

Sono tanti gli artisti che hanno abbracciato queste tecnologie, a partire da Kiesza e Stromae che l’anno scorso hanno collaborato a “Hello World”, l’album prodotto dal compositore francese Benoit Carré e pubblicato con lo pseudonimo SKYGGE. Taryn Southern, attrice statunitense fuoriuscita da American Idol, ha debuttato nel 2018 con un disco palindromo, “I AM AI”, cantato dalla performer ma composto, suonato e prodotto dal software open source Amper, l’ultimo arrivato tra i programmi che si occupano di composizione musicale – Wikipedia li ha raccolti in una lunga lista pubblicata sulla pagina “Music and artificial intelligence”.

Il primo a pensare che una macchina si sarebbe potuta occupare della scrittura dei testi delle canzoni è stato invece David Bowie – non poteva essere diversamente. Nel 1995 sviluppò insieme a un amico the Verbasizer, una Mac App, o per meglio dire “a digital version of an approach to lyrical writing that Bowie had been using for decades, called the cut-up technique”.

L’era dello streaming, figlia di Napster e degli sconvolgimenti portati da internet, di per sé ha già rivoluzionato le modalità di fruizione della musica, ma potrebbe anticipare un altro capovolgimento dalle implicazioni ancora più profonde: l’abdicazione della figura dell’artista in favore dei computer. È un argomento controverso che mette in gioco il concetto stesso di creatività. L’idea di genialità, che l’arte non possa prescindere dall’artista e il pallino sia sempre nelle mani di quest’ultimo sta iniziando lentamente a vacillare. Scrive Dani Deahl su The Verge:

“Facendo musica, l’idea che il linguaggio informatico possa fare quello che faccio io lascia spiazzati. È inquietante pensare che un algoritmo possa creare una canzone accettabile in qualche minuto e che l’intelligenza artificiale stia entrando in un territorio creativo che caratterizziamo come distintamente umano.”

Anche se è ancora strano da pensare, i computer stanno riuscendo a creare brani orecchiabili, e se il prodotto rispecchierà gli stessi standard della nostra canzone preferita – in realtà è già così – dovremo prepararci ad accettare il cambio di prospettiva e farcene una ragione: l’artista non sarà più l’unico tenutario delle idee su cui si costruiscono le canzoni.

Leggi anche: La trap impazzisce per Tesla. Elon Musk ringrazia

L’applicazione di queste tecnologie in campo musicale, oltre a smantellare parte del fascino legato alla scrittura dei pezzi e a smontarne la sovrastruttura romantica, potrebbe inoltre rivoluzionare i meccanismi dell’industria discografica: dalla distribuzione, ancora sentimentalmente — più che economicamente — legata al supporto fisico, alla promozione, basata su eventi e firmacopie dalle code infinite in cui viene concessa ai fan la possibilità di avvicinarsi per una manciata di secondi all’artista. Oppure ai concerti, giocati sulla diversificazione dell’esperienza del live e sulla creazione di aree pit fronte palco esclusive dalle quali potersi godere lo spettacolo pagando un prezzo maggiorato. Nei prossimi decenni — si, siamo ancora abbastanza distanti dal poterci permettere di abbandonare definitivamente il nostro cantante pop preferito — l’industria discografica potrebbe essere interessata da un cambiamento che, escludendo completamente l’essere umano dalla creazione della musica, si troverebbe all’improvviso rivoltata dalle fondamenta.

Insomma non ci sarà più bisogno di andare ai concerti, non andremo più alle presentazioni dei dischi, non esisteranno più supporti fisici, non ci saranno più le reunion e non si festeggeranno più gli anniversari. Ma soprattutto, se tutto andrà come deve andare, a Natale ci saremo finalmente sbarazzati di Michael Bublè e l’avremo sostituito con questa “bella” melodia metallica:

[soundcloud url=”https://api.soundcloud.com/tracks/537162570″ params=”color=#ff5500&auto_play=false&hide_related=false&show_comments=true&show_user=true&show_reposts=false&show_teaser=true&visual=true” width=”100%” height=”300″ iframe=”true” /]