Il bisogno di trovare spiegazioni razionali alla vittoria elettorale di Donald Trump in questi giorni sta facendo tenere molte dita e molti occhi puntati contro Facebook, accusato di aver favorito in una certa misura l’elezione del tycoon repubblicano con i propri meccanismi selettivi e distorsivi dei contenuti del “news feed” — verrebbe da dire, della realtà.

L’abbiamo scritto anche noi: Donald Trump è il primo presidente della filter bubble, come si chiama comunemente la droga a base di algoritmi che trasforma il nostro Facebook in un posto magnifico in cui tutti la pensano come noi — e dove, quindi, tutti hanno votato per Zoltan Istvan.

Se non altro, la presa di potere di una banda di cripto-nazisti alla Casa Bianca ha avuto questo di positivo: l’aver portato al centro del dibattito un problema serissimo di cui si discute da svariati anni, ma solo fra pochi interessati. La vittoria di Trump è stata una sorta di risveglio collettivo, uno schiaffo tanto più forte quanto più inaspettato. E proprio come quando ci si risveglia da un incubo (o in un incubo, date le circostanze), la prima reazione è stata quella di cercare di venire affannosamente a patti con la realtà presente, e darle un senso.

Le accuse contro il social network di Menlo Park si possono suddividere in almeno tre filoni:

1) Facebook ha contribuito a cementare il consenso elettorale di Donald Trump, e quindi alla sua vittoria;

2) Facebook ha inquinato la percezione della realtà politica, gonfiando le aspettative di una vittoria di Hillary Clinton;

3) Entrambe le cose.

Sul primo punto, alcuni commentatori sono stati molto tranchant: su select all, l’inserto di tecnologia del New York Magazine, Max Read ha scritto un articolo dal titolo inequivocabile: “Donald Trump ha vinto per colpa di Facebook.” A supportare l’argomentazione sono citati innanzitutto i contenuti virali pro-Trump, che hanno circolato durante la campagna con un’abbondanza senza precedenti, tanto da formare un vero e proprio universo autonomo all’interno della social-sfera. Spesso notizie false, spesso sfruttate unicamente per muovere traffico e generare rendite pubblicitarie, al di là di qualsiasi finalità ideologica.

Alcune sono diventate proverbiali, come la storia dell’endorsement a Trump di papa Francesco. Su NiemanLab, l’osservatorio sui media e sull’informazione dell’Università di Harvard, Joshua Benton ha sottolineato la sproporzione che c’è tra una storia falsa, fatta apposta per circolare entro un certo tipo di pubblico, e il suo relativo antidoto: il debunking di Snopes — un sito specializzato nel smontare bufale — è stato condiviso su Facebook solo 33 mila volte contro 868 mila. E molto probabilmente nessuno di questi 868 mila l’avrà letto — è così che funziona la selezione dei contenuti basata sulle nostre interazioni con ciò che ci piace: crea mondi separati e incomunicabili.

The pope’s “[Trump] endorsement” has over 868,000 Facebook shares; Snopes piece exposing it as fake only has 33,000: https://t.co/XbKOM0aDK8

— Violet Blue® (@violetblue) November 10, 2016

È così che il punto 2) si intreccia al primo: la mattina del 9 novembre è stata una brutta sorpresa per i moltissimi che, semplicemente, non si aspettavano che gli elettori di Trump fossero così tanti. Ma qui è veramente difficile incolpare Facebook di una miopia politica che ha colpito allo stesso modo i comuni cittadini e gli analisti politici più navigati — la mattina del 9 novembre in molti si sono svegliati accorgendosi di aver perso il polso della realtà. I social network non sono gli unici creatori di filter bubble: qualsiasi società chiusa svolge questo ruolo per i propri membri, e infatti molti hanno chiamato in causa la concentrazione della maggior parte dei giornalisti sulle due coste degli Stati Uniti, dove vivono e lavorano nelle isole felici e liberal delle grandi città o dei campus universitari. Diciamo così: ci saremmo potuti arrivare prima (e qualcuno, infatti, ci è arrivato).

Il cattivo lavoro che è stato fatto nella lettura e nella interpretazione dell’elettorato americano è in gran parte imputabile a una forma di pigrizia intellettuale. Anche in questo il trionfo del tycoon è servito da lezione: ha fatto capire che i sommovimenti politici nelle nostre società sono più complessi e richiedono analisi più approfondite e ponderate di quanto non sia stato fatto — e molte analisi approfondite e ponderate stanno infatti arrivando ora, ex post.

I giornalisti hanno puntato il dito contro Facebook e Google per poter alleggerire almeno un po’ le proprie responsabilità. Una ricerca molto citata del Pew Research Center rivela che il 44 percento dei cittadini statunitensi utilizza Facebook come principale mezzo di informazione — ma di questi, quanti avranno votato Trump? E quanti si saranno convinti a farlo soltanto dopo aver letto dell’omicidio-suicidio dell’agente dell’FBI che stava indagando sullo scandalo delle email di Hillary Clinton? Impossibile quantificarlo, e di sicuro esagerare il peso di questo elemento sul risultato del voto è riduttivo. Nondimeno, il problema della diffusione della disinformazione online è reale e sotto gli occhi di tutti.

Lo stesso Mark Zuckerberg non ha potuto tacere al riguardo. Dopo un commento a caldo piuttosto generico e equidistante, in cui diceva soltanto che bisogna tutti lavorare più duramente per “migliorare il mondo,” il fondatore di Facebook ha esplicitamente rigettato come “da matti” l’idea che il suo social network possa aver influenzato l’esito elettorale, dicendo che il 99% dei contenuti condivisi sono autentici.

È di oggi, però, la notizia che anche il social di Menlo Park intende seguire la strada tracciata da Google, che ha annunciato ieri di voler impedire ai siti che diffondono notizie false di utilizzare AdSense, tagliando in questo modo gran parte dei loro introiti pubblicitari.

Google says it will ban fake-news sites from using AdSense, which could crimp revenue on those sites. Story coming to @WSJ

— Scott Thurm (@ScottThurm) November 14, 2016

[column size=one_half position=first ]

Facebook farà lo stesso con la propria rete pubblicitaria Audience Network. Secondo BuzzFeed, si starebbe preparando addirittura una task force speciale, dedicata a combattere la diffusione di contenuti fasulli. Funzionerà? Difficile immaginare di sì: gli scorsi tentativi — dalla modifica all’algoritmo per penalizzare il clickbait allo scandalo dello staff editoriale incaricato di filtrare i “trending topic” che avrebbe deliberatamente soppresso notizie pro-repubblicani, fino al caso della foto “napalm girl” censurata — non sono andati molto bene.

[/column]

[column size=one_half position=last ]

In realtà, pretendere da Facebook un filtraggio editoriale sui contenuti diffusi dagli utenti è ancora più pericoloso che lasciare tutto così com’è — un classico caso in cui la cura rischia di essere peggio della malattia.

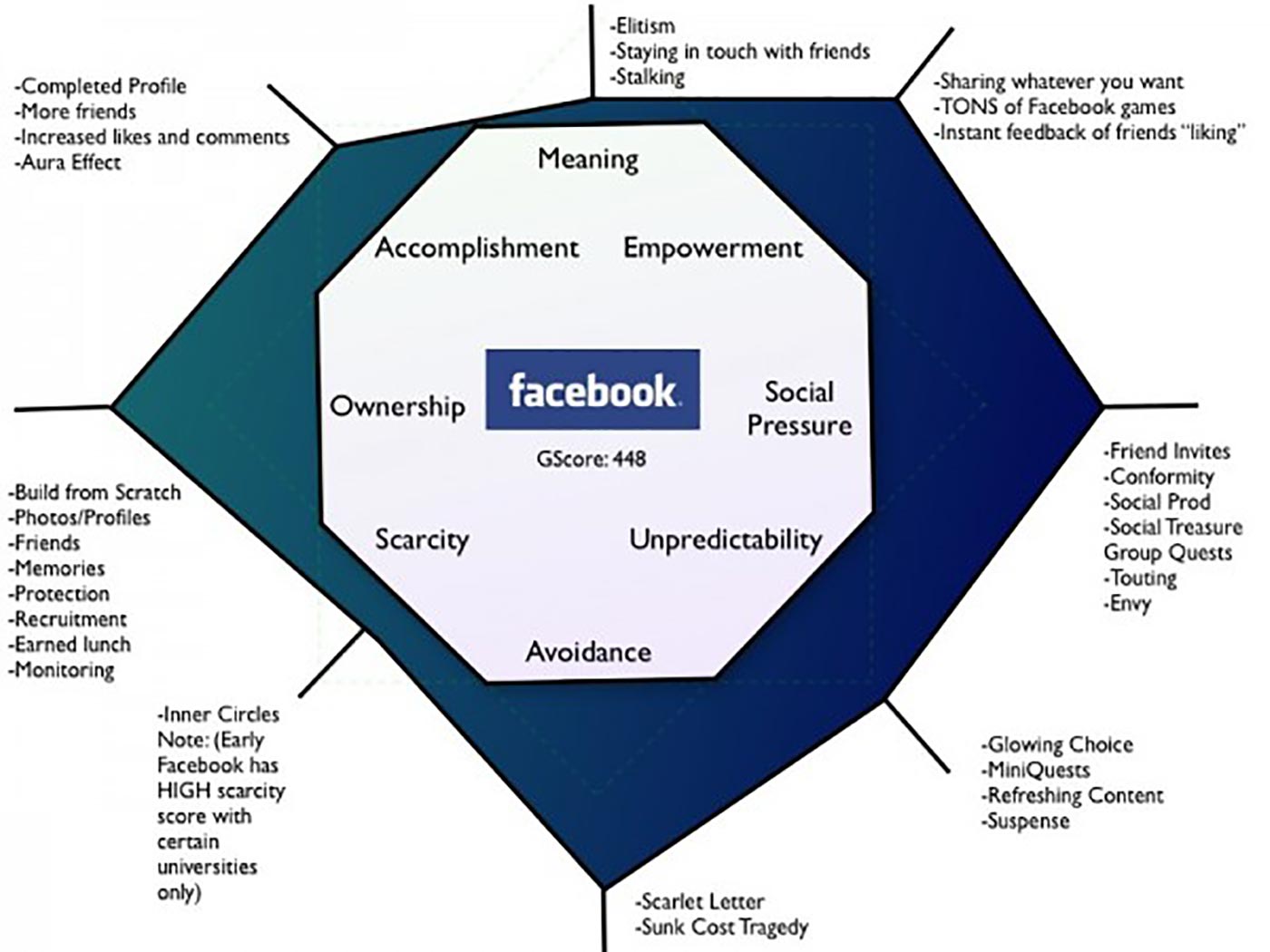

[/column]

In realtà, pretendere da Facebook un filtraggio editoriale sui contenuti diffusi dagli utenti è ancora più pericoloso che lasciare tutto così com’è — un classico caso in cui la cura rischia di essere peggio della malattia. Non soltanto questo tipo di filtraggio (basato essenzialmente sulle segnalazioni degli altri utenti) si è già rivelato inefficace e spesso finisce per colpire i bersagli sbagliati, ma la diffusione di bufale, clickbait e notizie tendenziose non esaurisce il problema di fondo del consumo di notizie sui social network — un problema che non potrà mai essere eliminato, perché è parte integrante della loro struttura, basata sulle interazioni e organizzata secondo feed personalizzati.

Un esempio sono le tempistiche: leggere notizie su Facebook, con la cadenza casuale e saltuaria che dedichiamo allo scrolling tende a eliminare la percezione della concatenazione cronologica tra gli eventi. Leggiamo decine e decine di titoli abbinati a immagini e brevi commenti, ma è successo oggi? Ieri? L’anno scorso? Così capita spesso che utenti poco attenti condividano anche a qualche anno di distanza la notizia della morte di qualche personaggio famoso — che semplicemente, nel loro consumo discontinuo di informazione, si erano persi.

Un altro esempio, classico, è la satira, specialmente quando si trova pubblicata su siti non specialmente dedicati (come Lercio o The Onion). Faccio un esempio tratto dai miei contatti: qualcuno l’altro giorno ha visto questo pezzo satirico sul New Yorker, che titolava “Trump conferma di aver appena cercato su Google Obamacare,” e l’ha condiviso credendo si trattasse di una notizia vera — poi si è accorto dell’errore, ma per puro caso.

Come dovrebbe comportarsi la task force anti-bufale di Facebook in questo caso? Di chi è la colpa?

Non servono a nulla censure e filtri: chi vuole leggere qualcosa troverà sempre qualcuno disposto a fargliela leggere. Al contrario, è sempre più evidente la necessità di un’educazione al consumo dei mezzi di informazione, che risolva il problema dal lato degli utenti. Un’educazione all’utilizzo critico degli strumenti digitali, di modo che gli utenti siano consapevoli che quando sfogliano il proprio news feed su Facebook non si stanno informando in modo adeguato, e dovranno ricorrere ad altre fonti per integrare una conoscenza parziale — come possono essere parziali le chiacchiere tra amici, notoriamente soggette a filter bubble — di ciò che succede nel mondo.

Il problema riguarda da vicino anche l’Italia, dove esiste un universo online di disinformazione, o informazione parziale e propagandistica, simile a quello che ha supportato Trump, orbitante in gran parte attorno al Movimento 5 Stelle. Per farla breve: più che bloccare le entrate pubblicitarie o impedire la circolazione di certe testate e pagine Facebook, bisogna dare agli utenti gli strumenti per riconoscere che non è lì che si trova l’informazione.

Un tormentone del dibattito scolastico in Italia è la famosa ora di lettura del giornale in classe. Ecco: ora più che mai sarebbe necessaria un’ora di alfabetizzazione digitale critica — non solo nelle scuole.