Facebook sfrutta le debolezze emozionali degli adolescenti per vendere pubblicità

Le rivelazioni dell’Australian disegnano uno scenario in cui il canale di comunicazione più diffuso al mondo è in grado di influenzare i sentimenti degli utenti.

Le rivelazioni dell’Australian disegnano uno scenario in cui il canale di informazione e comunicazione più diffuso al mondo non solo è in grado di tracciare e identificare umori, ma che attivamente influenza questi sentimenti.

Ieri The Australian ha pubblicato il contenuto di un documento riservato relativo alle ricerche di “profilazione emozionale” condotte da Facebook sugli utenti più giovani, dai quattordici anni in su.

Profilazione emozionale, ovvero: sfruttare gli algoritmi del social network per mappare con la massima precisione le oscillazioni d’umore nella fascia d’età in cui sono più frequenti, e utilizzare questi dati per — c’è bisogno di dirlo? — vendere pubblicità personalizzata ancora di più.

Il report, preparato da due dirigenti di Facebook Australia e destinato a un inserzionista, snocciola con inquietante freddezza la gamma di stati d’animo adolescenziali che il social network è in grado di individuare, studiando i post, le interazioni e l’attività su internet in generale — che Facebook è in grado di monitorare attraverso i suoi onnipresenti tracker — di oltre sei milioni di studenti liceali, universitari e giovani lavoratori: “stressato,” “abbattuto,” “sopraffatto,” “ansioso,” “nervoso,” “stupido,” “sciocco,” “inutile,” “un fallimento.”

È possibile anche tracciarne l’andamento settimanale: “Emozioni di aspettativa sono espresse con maggiori probabilità nei primi giorni della settimana, mentre stati d’animo riflessivi aumentano nel weekend,” si legge nel report.

“Il lunedì e il martedì servono per costruire sicurezza. Il weekend, per comunicare i risultati raggiunti.” (Beati i millennial australiani: a me i giorni della settimana sembrano tutti brutti allo stesso modo.)

Facebook non ha reagito bene a questo palese sbandieramento dei propri metodi aggressivi di profilazione pubblicitaria, che indignano soprattutto perché riguardano la fascia più debole e meno tutelata degli utenti di internet. Contattati da The Australian, i rappresentanti del social di Menlo Park hanno dichiarato che “i dati su cui è basata questa ricerca sono stati aggregati e presentati in osservazione della tutela legale della privacy, inclusa la rimozione di ogni informazione identificativa personale,” chiedendo scusa, però, per aver usato come target un bacino di utenza così giovane, e annunciando l’apertura di un’indagine interna al riguardo.

“Facebook consente soltanto ricerche che seguano un rigoroso processo di verifica, ogni volta che dati sensibili, in particolar modo se coinvolgono persone minorenni o il loro comportamento emozionale. Questa ricerca sembra non aver seguito questo processo.”

In un post pubblicato più tardi, si legge che “l’analisi condotta aveva lo scopo di aiutare i venditori a capire come le persone si esprimono su Facebook. Non è mai stata usata per personalizzare annunci pubblicitari ed era basata su dati anonimi e aggregati.”

Ma non è la prima volta che uno spaccato ci rivela quanto in profondità Facebook conosca e controlli lo stato d’animo dei propri utenti. Durante l’estate del 2014 in uno studio pubblicato dall’Università di Princeton era emersa la facilità con cui il servizio poteva trasformarsi in un pericoloso vettore di contagio emotivo: estrapolando il contenuto di ogni post e la sua possibile reazione, un algoritmo può infatti facilmente influenzare lo stato d’animo dei propri utenti.

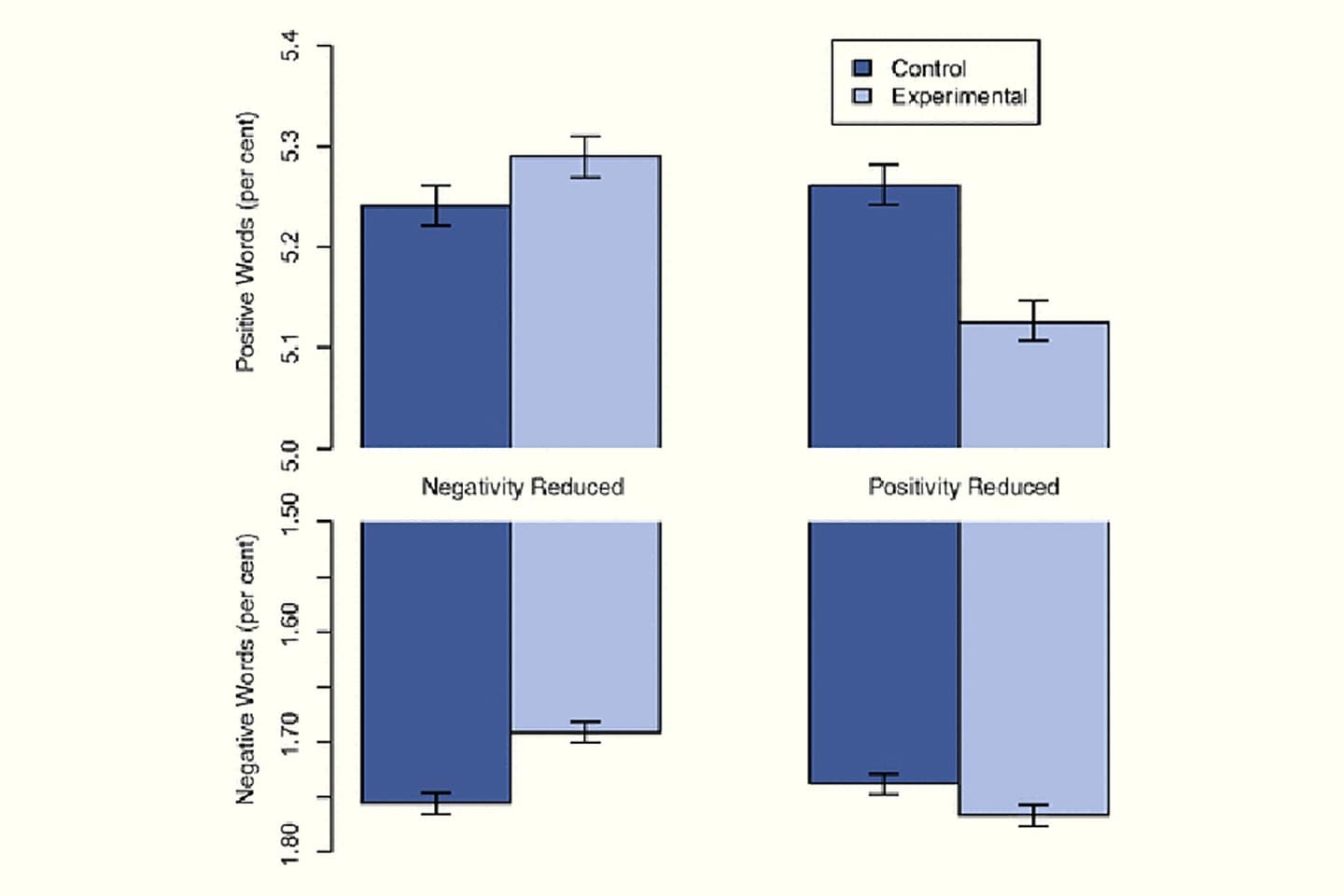

Lo studio — di proporzioni gigantesche, con un campione di 689 mila utenti — mostra come il social network possa operare un contagio emotivo semplicemente alterando la quantità di termini positivi e negativi all’interno di un feed. Ogni persona influenzata diventa a sua volta un vettore sui news feed dei propri amici.

Dopo aver in un primo tempo minimizzato, sostenendo che i risultati non erano nemmeno particolarmente impressionanti, Facebook ha poi dovuto fare marcia indietro, seppur sempre garantendo che non fossero stati raccolti dati personali nel corso della ricerca.

In uno studio dell’ottobre 2015 Galen Panger, ricercatore di Berkeley, approfondisce un fronte che nel dibattito durante l’anno precedente era in qualche modo caduto in secondo piano: gli effetti dei social network sul benessere emotivo della popolazione. La manipolazione del News Feed, che Facebook ha chiaramente operato con regolarità, potrà pure produrre dati statisticamente non rilevanti, ma questi dati sono costati comunque moltissimo in termini di “felicità” degli utenti sottoposti inconsapevolmente allo studio.

Il rapporto tra capitalismo e “felicità,” intesa in senso più ampio come benessere mentale, è sempre stato conflittuale: se, secondo uno studio del 2010 di un team di economisti guidati da Andrew Oswald, dipendenti felici arrivano a produrre fino al 12% in più rispetto a dipendenti prostrati, l’interminabile ciclo di consumo e desiderio di arricchirsi è inerentemente abbrutente. Nel caso specifico emerso dal documento trafugato di Facebook, però, per la prima volta emerge un dato chiaro, non solo analizzato da accademici che voci neoliberiste potrebbero considerare polverosi e libreschi, ma dalla stessa azienda che opera nell’industria.

Forse l’elemento che più legava Facebook e Instagram (prima dell’acquisizione) era l’abuso della retorica del narcisismo positivo. Il narcisismo positivo, codificato sistematicamente per la prima volta da Otto Kernberg e Heinz Kohut negli anni ’70, è la “quantità” sana di narcisismo, caratteristica di personalità necessaria per raggiungere un equilibrio sano di autostima. Giustificare l’over-sharing come strumento di narcisismo positivo è un’ottima scusa da parte di colossi che vivono grazie all’inserimento volontario di dati da parte degli utenti.

In questo modo viene a instaurarsi una sorta di circolo vizioso: Facebook è in grado di influenzare lo stato emotivo dei propri utenti, attraverso lievi modifiche parametriche al News Feed, come ha dimostrato lo studio di Princeton (in cui gli utenti sono serviti, esattamente come nel caso australiano, da cavie da laboratorio). Dall’altra parte, il social network studia e traccia le stesse variazioni emozionali che può indurre, per poter vendere agli inserzionisti lo spazio pubblicitario giusto al momento giusto.

Ne deriva, potenzialmente, uno scenario da incubo di sistematico sfruttamento emotivo a fini pubblicitari.

È il prezzo che siamo disposti a pagare in cambio dei servizi che Facebook ci offre gratuitamente? La gratuità in un certo senso si lega anche a un’aura di “naturalità,” ottenuta nascondendo il più possibile tutto ciò che accade dietro le quinte. Ma il modello non è naturale e deve essere messo in discussione. Anche senza ipotizzare la trasformazione di Facebook in un ente di diritto pubblico sottoposto a controllo democratico, il problema riguarda, nello specifico, la libertà quasi assoluta con cui il social network può disporre privatamente dei dati dei propri utenti, a cui vengono garantite tutele legali del tutto insufficienti. Una delle sfide per le politiche digitali del futuro — se non saranno decise direttamente da Menlo Park — sarà proprio imporre una limitazione a quest’arbitrio.

Le rivelazioni dell’Australian disegnano uno scenario in cui il canale di informazione e comunicazione più diffuso al mondo non solo è in grado di tracciare e identificare umori, ma che attivamente influenza questi sentimenti, e quando ne ha l’occasione ne abusa. La domanda è inevitabile: se utenti insicuri e affetti da forme proto-depressive sono più redditizi, e Facebook può controllare i sentimenti dei propri utenti, che interesse ha a favorire un ambiente, e quindi, un mondo, più sereno?