Benvenuti nel capitalismo della sorveglianza

Echo Look, la nuova fotocamera di Amazon che vi dice se siete vestiti bene al mattino, è il prossimo passo nel nostro costante slittamento verso l’autoritarismo.

Echo Look, la nuova fotocamera di Amazon che vi dice se siete vestiti bene al mattino, è il prossimo passo nel nostro costante slittamento verso l’autoritarismo.

Ieri pomeriggio Amazon ha presentato un nuovo prodotto della linea Echo — gli altoparlanti musicali che contengono anche un assistente personale, stile Siri — chiamato Alexa. Secondo le voci di corridoio, il nuovo prodotto avrebbe dovuto contenere anche uno schermo, rendendo il nuovo Echo una sorta di tablet da cucina, o da salotto.

Le voci, ora è abbastanza chiaro, venivano dal reparto marketing, perché il nuovo prodotto si chiama Echo Look — ma non siete voi a guardarlo, è il contrario.

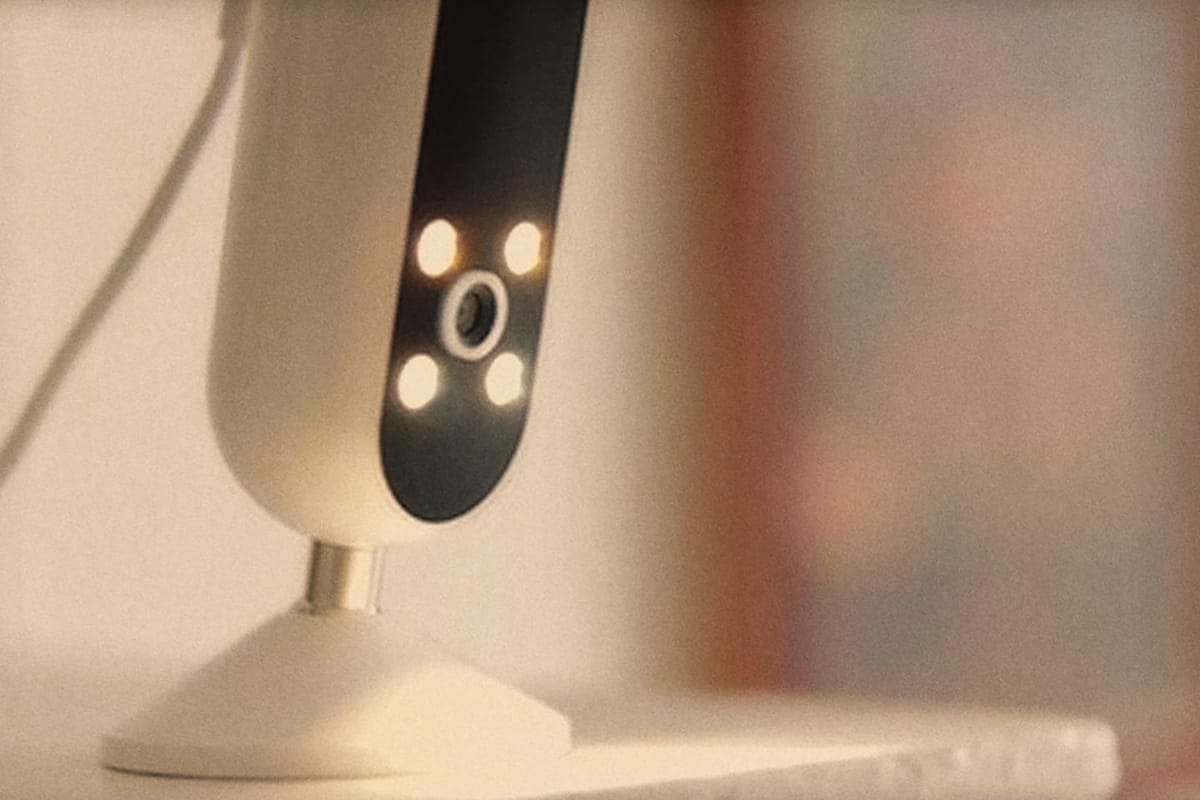

Echo Look è un sistema audio con anche una fotocamera. Si può usarlo come qualsiasi altro speaker per parlare con Alexa e ascoltare musica, ma gli si può anche chiedere di scattare foto. Non foto qualsiasi: Echo Look è presentato ai clienti come una sorta di “specchio smart”, può scattare foto di come siete vestiti, e valutare se state bene. “Quel giacchino non funziona con quel vestito, meglio un cardigan a righe” — le foto appaiono su un’app per smartphone con variabili di stile. Lo scopo, nemmeno troppo nascosto, è creare una linea di contatto diretto tra il vostro “specchio” e la vendita di moda diretta di Amazon. Non riuscite a trovare nemmeno un paio di scarpe che stia bene con quel vestito? Bisognerà comprarne un altro paio.

A 199 dollari, Echo Look è posizionato come un prodotto di lusso: fatichiamo a credere che possa riprodurre musica con una qualità del suono paragonabile a qualsiasi speaker in vendita anche solo alla metà del suo prezzo — è troppo piccolo, e c’è troppa altra tecnologia dentro. No, malgrado le altre funzioni, questo è chiaramente un gadget con uno scopo solo: valutare come vi vestite, e se vi vestite male, invitarvi a comprare vestiti più belli da Amazon.

Insomma, è uscito da una puntata di Black Mirror così com’è, senza pensare alle implicazioni di privacy e, più in generale, di come funziona il capitalismo.

Dietro le quinte, le foto scattate da Echo Look sono processate dagli algoritmi di intelligenza artificiale che muovono gli altri prodotti della famiglia. Finora, tuttavia, ogni volta che abbiamo chiesto a intelligenze artificiali di valutare o modificare foto, abbiamo scoperto che i risultati sono sempre profondamente razzisti e sessisti — non è chiaro esattamente perché. L’ipotesi più diffusa è che si tratti di confirmation bias, ovvero gli algoritmi sarebbero addestrati, plagiati in qualche modo, sul gusto dei propri programmatori: man–child bianchi californiani nel caso delle app occidentali, piegati al gusto orientale per le tante app di filtri e social orientali.

Il caso più recente è quello di FaceApp, un’app che genera filtri automatici che rendono più belli, più anziani, o invertono il genere. Tantissimi utenti di colore hanno realizzato nelle scorse settimane che il network neuronale dietro i filtri dinamici dell’app sostanzialmente schiariva la loro faccia e correggeva il loro naso per renderlo più conforme ai canoni di bellezza… chiamiamoli così: europei.

#faceapp isn't' just bad it's also racist…🔥 filter=bleach my skin and make my nose your opinion of European. No thanks #uninstalled pic.twitter.com/DM6fMgUhr5

— Terrance AB Johnson (@tweeterrance) April 19, 2017

Ma quello di FaceApp non è un caso unico, o raro. In uno studio pubblicato sulla rivista Science, Joanna Bryson dell’Università di Bath sottolinea come non siano gli algoritmi “innatamente” razzisti, ma che si tratti di un fattore di imprinting legato a luoghi comuni del linguaggio e della psiche della società. A livello linguistico, Bryson ha addestrato una macchina a collegare nomi e parole con sensazioni e aree di interesse: il risultato è stato che la macchina ha imparato a collegare nomi femminili all’ambito dell’Umanesimo e delle arti, ha imparato ad associare nomi europei e inglesi con parole positive, come “regalo,” e “felicità,” e parole negative con nomi afroamericani.

Ad inizio anno, in un report accessibile su SSRN, Sandra Wachter, Brent Mittelstadt, e Luciano Floridi hanno teorizzato la necessità di costruire un “cane da guardia” per proteggere le persone da possibile discriminazione da algoritmi.

La ricercatrice di sociologia all’Università di New York e opinionista del New York Times Zeynep Tufekci teorizza che ci si stia trovando di fronte non all’inizio dell’intelligenza artificiale, ma a un evento più ampio: uno slittamento verso l’autoritarismo, reso possibile solo grazie a prodotti esattamente come l’Echo Look. È il capitalismo della sorveglianza.

Cosa può fare un’intelligenza artificiale con vostre foto a figura intera scattate quotidianamente? Può rivelare i segni di una gravidanza prima che lo scopriate? Può osservare casi di depressione prima che si presentino sintomi fisici? Può misurare lo stato di stress di una persona?

E soprattutto, tutti questi dati che naturalmente un’intelligenza artificiale può interpolare, per quanto tempo rimarranno isolati da datori di lavoro, assicurazioni sanitarie private, lo stato?

Sia chiaro: ciò che rende inevitabile l’imminente ubiquità di infrastrutture per la sorveglianza non è semplicemente la malvagità, o i secondi fini dei governi del mondo, ma quanto sia sempre più evidente che la sorveglianza è a tutti gli effetti la sola valvola di sfogo rimasta, forse l’ultima, di sviluppo capitalista della società. La vendita di attenzione e informazione è effettivamente l’unico nuovo mercato di questo secolo, è un mercato che non solo è estremamente proficuo, ma che permette di ottimizzare la performance di tantissime altre attività circostanti — come la vendita di scarpe su Amazon. La sorveglianza amplifica grandemente i potenziali di mercato di tantissimi servizi — che a tutti gli effetti possono esistere solo grazie a questi modelli di business — gli Stati, in cambio di questa infrastruttura, non stanno attuando politiche di regolazione su queste nuove frontiere, come invece si è fatto su ogni altra industria in precedenza.

E il pubblico, nel frattempo, perde gradualmente il senso di privacy, accettando un compromesso dietro l’altro in cambio di facilità d’uso e esperienze utente più snelle, nel frattempo rassicurandosi: “no, Donald Trump non vincerà le primarie,” “no, non può vincere le elezioni,“ “no, non farà le cose terribili che aveva detto.” “No, il Regno Unito non voterà per la Brexit,” “no, la Francia non eleggerà mai Le Pen.” Lentamente, però, questi governi gradualmente sempre più autoritari si stanno insediando, e l’infrastruttura per un potenziale fascismo del ventunesimo secolo si fa sempre più efficace.